PPO 在实现简单性、样本复杂度和调参难度之间取得了平衡

background

策略梯度法(Policy gradient method)是近来使用深度神经网络进行控制获得种种突破的基础。但是,通过策略梯度法取得很好的结果十分困难,因为它对步长大小(stepsize)的选择十分敏感。如果迭代步长太小,那么进展会很慢,如果迭代步长过大,那么信号将遭到噪声的强烈干扰,性能急剧降低。此外,策略梯度法样本效率非常低,需要几百万(乃至几十亿)时间步骤(timestep)学习一个简单的任务。

研究人员尝试使用 TRPO 和 ACER 等方法来减少这些缺陷,TRPO 和 ACER 等方法能够约束或优化一次策略更新(policy update)大小。这些方法也都有其各自的 trade-off,比如 ACER 要比 PPO 复杂,需要额外添加代码来修正离策略(off-policy)和重构缓冲器,TRPO 虽然对连续控制任务非常有用,但对于那些在策略和价值函数或辅助损失函数(auxiliary losses)间共享参数的算法兼容度很低,而后者恰好对于解决 Atari 等视觉输入很重要的领域的问题时很重要。

PPO

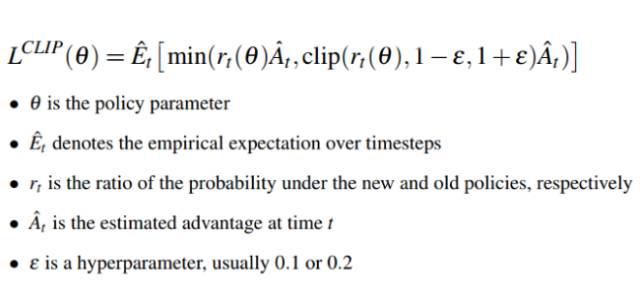

通过监督学习,我们可以轻松地实现成本函数,并在成本函数上运行梯度下降,只需相对少量调参就能得到很好的结果。让强化学习成功的路径并不明显,因为算法通常具有很多难以调试的活动模块,需要大量精力调整才能获得良好的效果。PPO 算法很好地在实现简单性、样本复杂度和调参难度之间取得了平衡,PPO 尝试在每一迭代步计算一个更新,将成本函数最小化,同时在计算梯度时确保与先前策略有相对较小的偏差。

这种目标函数实现了一种与随机梯度下降相匹配的置信域(Trust Region)更新,通过移除了 KL 惩罚,不需要更新,从而简化了算法。在测试中,PPO 在连续控制任务中取得了最好的性能,在 Atari 上取得了几乎能够与 ACER 相媲美的性能。